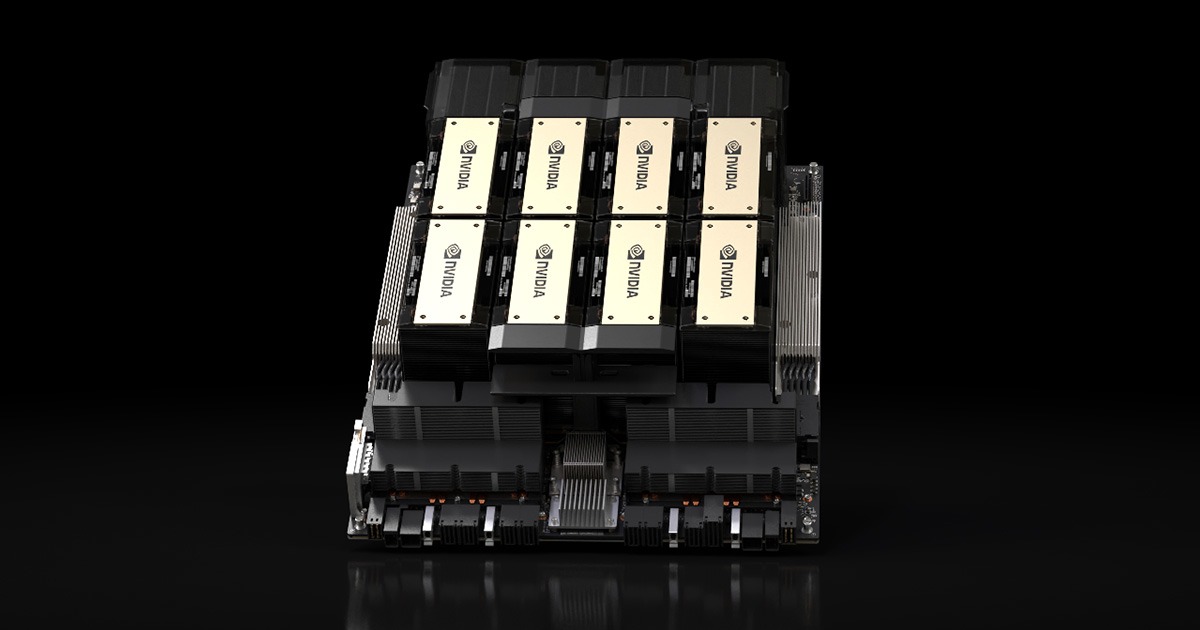

NVIDIA H200 Tensor Core GPU

產品概述

顛覆性的 AI 與 HPC 效能

NVIDIA H200 是第一款搭載 HBM3E 的 GPU,具備更大更快的記憶體,專為加速生成式人工智慧 (GenAI) 和大型語言模型 (LLM) 而生,同時能大幅強化高效能運算 (HPC) 工作負載的科學運算能力。透過 NVIDIA Hopper 架構,H200 大幅提升了全球頂尖人工智慧運算平台的效能。

效能突破與記憶體革新

體驗效能的全新境界

相較於前代產品,H200 展現了驚人的速度提升:

- Llama2 70B 推論:1.9 倍速度提升

- GPT3-175B 推論:1.6 倍速度提升

- 高效能運算:110 倍速度提升 (與 CPU 相比)

記憶體容量更大、速度更快

NVIDIA H200 採用 NVIDIA Hopper 架構,提供高達 141 GB 的 HBM3e 記憶體,容量幾乎是 H100 GPU 的兩倍;記憶體頻寬提升 1.4 倍,達到每秒 4.8 TB。這使其能夠處理龐大的資料集並加速複雜的運算模型。

應用場景優勢

透過高效能 LLM 推論取得洞察

隨著企業仰賴 LLM 進行推論,H200 在處理如 Llama2 70B 等大型模型時,可將推論效能大幅提升到最高 2 倍 (與 H100 相比)。這讓使用者能以最低的整體擁有成本 (TCO) 達到最高的傳輸量。

大幅強化高效能運算 (HPC)

記憶體頻寬是 HPC 的關鍵。在模擬、科學研究等記憶體密集型應用中,H200 的高頻寬能保障資料存取效率,減少處理瓶頸。在實際應用測試中,其取得結果的速度與 CPU 相比提升達 110 倍。

降低能耗與整體擁有成本

H200 與 H100 Tensor Core GPU 使用相同的功耗設定,卻提供無與倫比的效能,從而將能源效率和整體擁有成本 (TCO) 帶到新高。這讓人工智慧工廠和超級運算系統更快速且更環保。

多樣化部署與軟體支援

NVIDIA H200 NVL

專為主流企業伺服器設計,適合需要靈活配置的低功耗、氣冷企業機架。透過 NVLink™ 連結最多四款 GPU,記憶體提升 1.5 倍,為任何規模的 AI 和 HPC 工作負載提供加速。

NVIDIA AI Enterprise 軟體支援

H200 隨附五年 NVIDIA Enterprise 訂閱,包含易於使用的 NVIDIA NIM™ 微服務。這能簡化生成式 AI (如電腦視覺、語音 AI、RAG) 的開發與部署流程,提供企業級的安全性與管理能力。